ตอนที่ 2: สถาปัตยกรรมของระบบ Edge AI

บทนำ

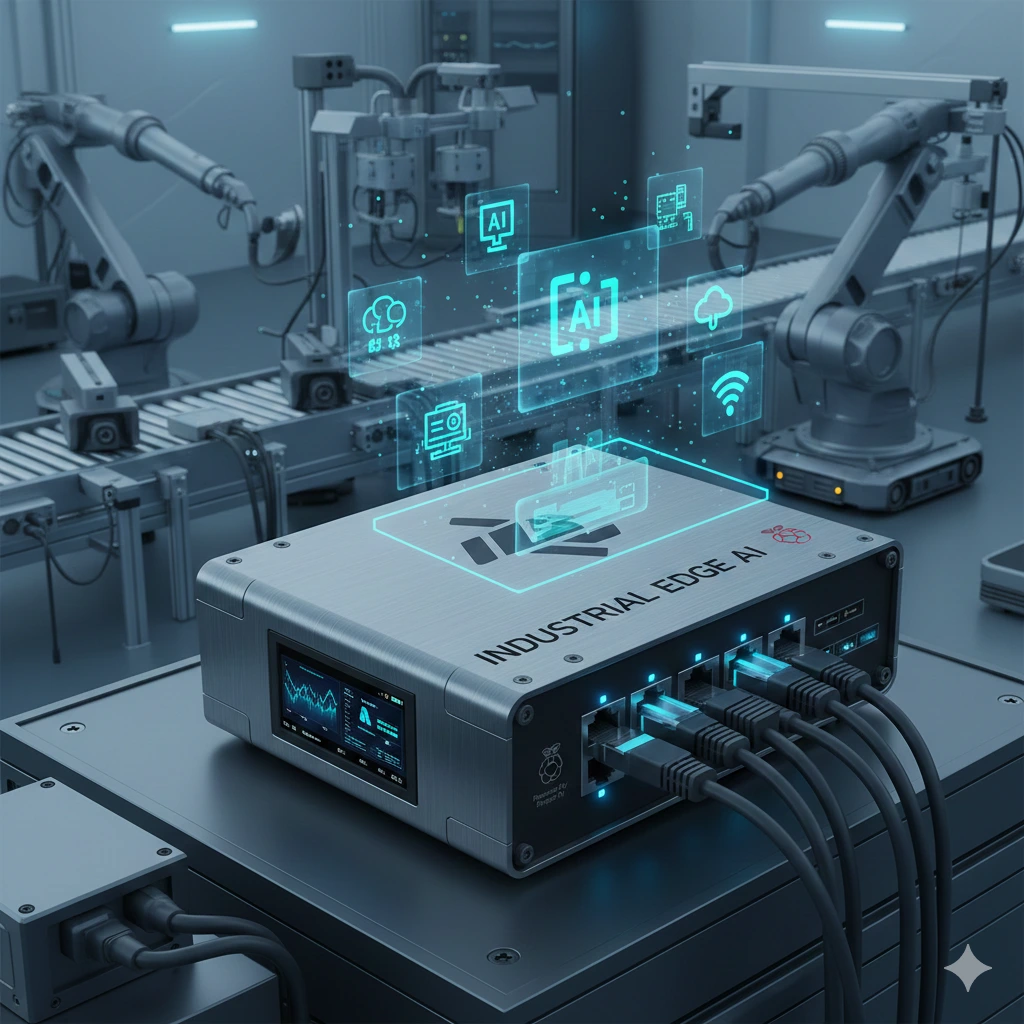

จากตอนที่ 1 ผู้อ่านได้ทำความเข้าใจแล้วว่า Edge AI คือแนวคิดการนำปัญญาประดิษฐ์ไปทำงานใกล้แหล่งกำเนิดข้อมูล เพื่อลดเวลาในการตอบสนอง เพิ่มความเป็นส่วนตัว และลดการพึ่งพาโครงสร้างพื้นฐานส่วนกลาง อย่างไรก็ตาม การนำ Edge AI ไปใช้งานจริงไม่ใช่เพียงการ “รันโมเดลบนอุปกรณ์ปลายทาง” เท่านั้น แต่จำเป็นต้องอาศัย สถาปัตยกรรมระบบ (System Architecture) ที่ออกแบบมาอย่างเหมาะสม

บทความตอนนี้มีเป้าหมายเพื่ออธิบายโครงสร้างและองค์ประกอบหลักของระบบ Edge AI ตั้งแต่ระดับอุปกรณ์ (Edge Device) การเชื่อมต่อผ่าน Gateway ไปจนถึงระบบ Backend รวมถึงการไหลของข้อมูล (Data Flow) และบทบาทของฮาร์ดแวร์เร่งความเร็ว AI บน Edge เพื่อให้ผู้อ่านสามารถ “วาดภาพระบบ Edge AI ในหลักการ” ได้อย่างชัดเจน

1. ภาพรวมสถาปัตยกรรมของระบบ Edge AI

โดยทั่วไป ระบบ Edge AI ไม่ได้เป็นสถาปัตยกรรมแบบชั้นเดียว (Single-layer) แต่เป็น สถาปัตยกรรมแบบกระจาย (Distributed Architecture) ที่ประกอบด้วยองค์ประกอบหลัก 3 ระดับ ได้แก่

Edge Device – จุดกำเนิดข้อมูลและการประมวลผลเบื้องต้น

Edge Gateway / Edge Server – ตัวกลางในการรวมข้อมูลและควบคุมระบบ

Backend / Cloud – ศูนย์กลางการจัดการ วิเคราะห์เชิงลึก และฝึกโมเดล

สถาปัตยกรรมลักษณะนี้ช่วยให้ระบบสามารถผสมผสานข้อดีของ Edge Computing และ Cloud Computing เข้าด้วยกัน โดยเลือกให้การประมวลผลที่ต้องการความเร็วสูงเกิดขึ้นใกล้หน้างาน ขณะที่งานที่ซับซ้อนหรือใช้ทรัพยากรสูงยังคงอยู่บน Backend

2. Edge Device: หัวใจของ Edge AI

2.1 บทบาทของ Edge Device

Edge Device คืออุปกรณ์ปลายทางที่อยู่ใกล้แหล่งกำเนิดข้อมูลมากที่สุด เช่น กล้อง เซนเซอร์ เครื่องจักร หรืออุปกรณ์ IoT หน้าที่หลักของ Edge Device ได้แก่

รับข้อมูลดิบจากเซนเซอร์ (ภาพ เสียง สัญญาณ)

ประมวลผลข้อมูลด้วยโมเดล AI

ตัดสินใจหรือกระทำการตอบสนองแบบเรียลไทม์

ส่งเฉพาะผลลัพธ์หรือข้อมูลสรุปไปยังระบบส่วนกลาง

ตัวอย่าง Edge Device ที่พบได้บ่อย ได้แก่

สมาร์ทโฟน, กล้องวงจรปิดอัจฉริยะ, Raspberry Pi, NVIDIA Jetson, ระบบควบคุมในรถยนต์ และเครื่องจักรในโรงงาน

2.2 ข้อจำกัดของ Edge Device

แม้ Edge Device จะมีบทบาทสำคัญ แต่ก็มีข้อจำกัดชัดเจน ได้แก่

พลังประมวลผลและหน่วยความจำจำกัด

ข้อจำกัดด้านพลังงานและความร้อน

ไม่เหมาะกับโมเดล AI ขนาดใหญ่

ข้อจำกัดเหล่านี้ส่งผลโดยตรงต่อการออกแบบสถาปัตยกรรม และนำไปสู่การใช้การประมวลผลแบบกระจาย

3. Edge Gateway: ตัวกลางของระบบกระจาย

3.1 หน้าที่ของ Edge Gateway

Edge Gateway ทำหน้าที่เป็นสะพานเชื่อมระหว่าง Edge Device จำนวนมากกับ Backend โดยทั่วไป Edge Gateway จะมีความสามารถมากกว่า Edge Device และทำหน้าที่ เช่น

รวมข้อมูลจาก Edge Device หลายตัว

กรอง ตรวจสอบ หรือประมวลผลข้อมูลในระดับกลาง

จัดการการสื่อสารกับ Backend

บังคับใช้นโยบายด้านความปลอดภัยและการเข้าถึง

ในบางระบบ Edge Gateway อาจเป็นอุปกรณ์เฉพาะ หรืออาจเป็นเซิร์ฟเวอร์ขนาดเล็กที่ติดตั้งอยู่ภายในโรงงานหรือไซต์งาน

3.2 บทบาทเชิงสถาปัตยกรรม

การมี Edge Gateway ช่วยลดภาระของ Backend และเพิ่มความยืดหยุ่นของระบบ โดยเฉพาะในกรณีที่

มี Edge Device จำนวนมาก

เครือข่ายไม่เสถียร

ต้องการควบคุมระบบแบบกึ่งอิสระ (Semi-autonomous)

4. Backend และ Cloud: สมองส่วนกลางของระบบ

4.1 หน้าที่หลักของ Backend

แม้ Edge AI จะเน้นการประมวลผลที่ปลายทาง แต่ Backend หรือ Cloud ยังคงมีบทบาทสำคัญ ได้แก่

การฝึก (Training) และปรับปรุงโมเดล AI

การจัดเก็บข้อมูลระยะยาว

การวิเคราะห์ข้อมูลเชิงลึก (Big Data Analytics)

การบริหารจัดการอุปกรณ์และโมเดล (Device & Model Management)

Backend เป็นส่วนที่ให้มุมมองเชิงระบบและเชิงกลยุทธ์ ซึ่ง Edge Device ไม่สามารถทำได้ด้วยตนเอง

4.2 Edge AI กับสถาปัตยกรรมแบบ Hybrid

ในทางปฏิบัติ ระบบ Edge AI ที่มีประสิทธิภาพมักอยู่ในรูปแบบ Hybrid Architecture คือ

Edge: ประมวลผลและตัดสินใจแบบเรียลไทม์

Cloud: วิเคราะห์ภาพรวม เรียนรู้ และปรับปรุงระบบในระยะยาว

5. Data Flow: การไหลของข้อมูลในระบบ Edge AI

5.1 ลำดับการไหลของข้อมูล

ในสถาปัตยกรรม Edge AI ข้อมูลจะไหลตามลำดับโดยทั่วไปดังนี้

เซนเซอร์สร้างข้อมูลดิบ

Edge Device ประมวลผลและสรุปผลลัพธ์

Edge Gateway รวมและจัดการข้อมูล

Backend รับข้อมูลเพื่อจัดเก็บ วิเคราะห์ หรือฝึกโมเดล

ที่สำคัญคือ ข้อมูลดิบจำนวนมากจะไม่ถูกส่งไปยัง Cloud แต่จะถูกแปลงเป็นข้อมูลที่มีคุณค่าแล้วตั้งแต่ระดับ Edge

5.2 แนวคิดการประมวลผลแบบกระจาย

แนวคิดนี้ช่วยให้ระบบ:

ลด Latency

ลด Bandwidth

เพิ่มความเป็นส่วนตัว

เพิ่มความทนทานต่อปัญหาเครือข่าย

6. ฮาร์ดแวร์เร่งความเร็ว AI บน Edge

6.1 เหตุผลที่ต้องใช้ฮาร์ดแวร์เฉพาะทาง

การรันโมเดล AI บน CPU ทั่วไปมักไม่เพียงพอสำหรับงานที่ต้องการความเร็วหรือพลังงานต่ำ จึงเกิดฮาร์ดแวร์เร่งความเร็วเฉพาะทาง เช่น

GPU on Edge – เหมาะกับงานประมวลผลขนาน

NPU (Neural Processing Unit) – ออกแบบมาสำหรับ Neural Network โดยเฉพาะ

TPU (Tensor Processing Unit) – เน้นการคำนวณ Tensor อย่างมีประสิทธิภาพ

6.2 บทบาทเชิงสถาปัตยกรรม

ฮาร์ดแวร์เหล่านี้ช่วยให้ Edge Device สามารถ:

รันโมเดลที่ซับซ้อนได้มากขึ้น

ใช้พลังงานต่อการคำนวณต่ำลง

รองรับการทำงานแบบเรียลไทม์

การเลือกฮาร์ดแวร์จึงเป็นส่วนหนึ่งของการออกแบบสถาปัตยกรรม ไม่ใช่เพียงการตัดสินใจเชิงเทคนิคเฉพาะจุด

บทสรุป

สถาปัตยกรรมของระบบ Edge AI เป็นผลลัพธ์ของการออกแบบระบบแบบกระจาย ที่ผสาน Edge Device, Gateway และ Backend เข้าด้วยกันอย่างสมดุล ผู้อ่านควรเห็นภาพว่า Edge AI ไม่ใช่ “กล่องดำหนึ่งกล่อง” แต่เป็นระบบที่มีหลายระดับ แต่ละระดับมีบทบาทและข้อจำกัดแตกต่างกัน

เมื่อเข้าใจโครงสร้างเหล่านี้แล้ว ผู้อ่านจะสามารถเริ่มต้นออกแบบระบบ Edge AI ในหลักการได้ ไม่ว่าจะเป็นการเลือกตำแหน่งการประมวลผล การวาง Data Flow หรือการเลือกฮาร์ดแวร์ที่เหมาะสม

เกริ่นนำตอนที่ 3

เมื่อเราเข้าใจแล้วว่า Edge AI ถูกสร้างขึ้นอย่างไร คำถามถัดไปคือ

เราควรเลือกใช้ Edge AI, Cloud AI หรือ Hybrid แบบใดจึงจะเหมาะสมกับโจทย์ของเรา?

ในตอนที่ 3 เราจะเปรียบเทียบทั้งสามแนวทางอย่างเป็นระบบ พร้อมกรอบการตัดสินใจ (Decision Framework) และตัวอย่างจากภาคอุตสาหกรรมจริง เพื่อช่วยให้ผู้อ่านสามารถเลือกสถาปัตยกรรมที่เหมาะสมกับบริบทของตนเองได้อย่างมีเหตุผลและคุ้มค่า